近日,中科院自动化所神经计算与脑机交互团队基于多模态表征学习和预训练生成模型提出了一种解耦语义、结构和运动信息的神经解码框架,从人脑响应中成功解码出了动态视频刺激。相关成果以Animate Your Thoughts: Reconstruction of Dynamic Natural Vision from Human Brain Activity为题发表于国际表征学习顶级会议ICLR2025。

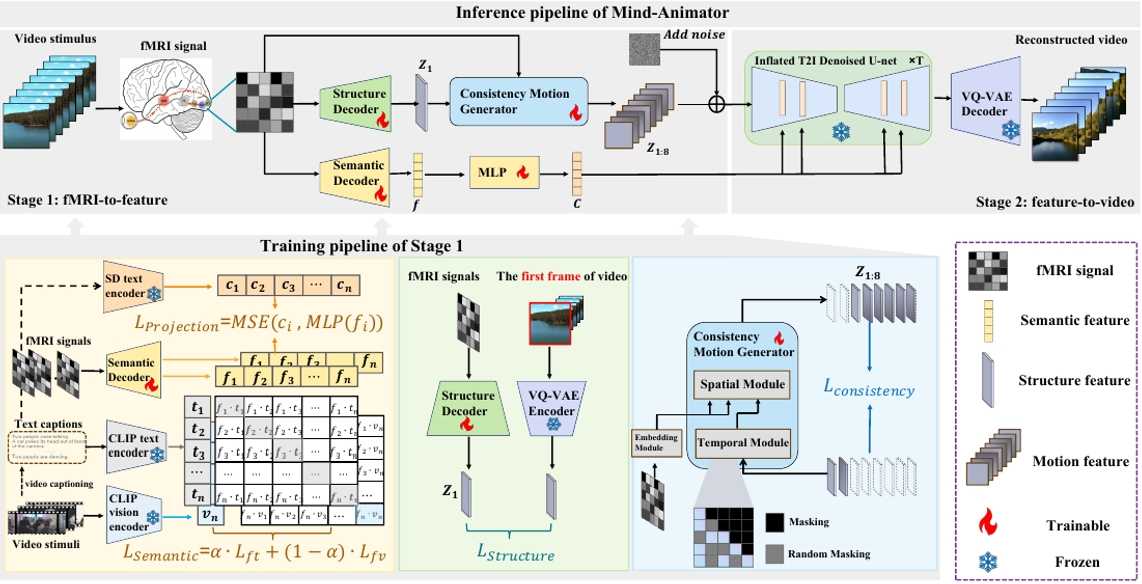

研究框架示意图

该研究的核心在于提出了一种名为“Mind-Animator”的两阶段模型。在第一阶段(fMRI到特征阶段),团队通过fMRI-视觉-语言三模态对比学习解码语义特征,并设计了一种稀疏因果注意力机制,通过“下一帧预测”任务解码多帧视频的运动特征。在第二阶段(特征到视频阶段),这些特征被整合到视频隐空间中,通过膨胀的Stable Diffusion模型生成最终的动态视频,有效避免了外部视频数据与解码运动特征的干扰。此外,研究团队通过排列测试验证了重建视频动态确实来源于fMRI数据,而非生成模型的“幻觉”,并通过对逐体素和逐ROI重要性地图的可视化进一步确认了模型的神经生物学可解释性。

这一成果不仅在3个公共数据集共16个被试上达到了行业领先水平,其可解释分析结果还为认知神经科学和脑机接口技术的发展提供了新的思路和方法。

本论文由中国科学院自动化研究所博士生卢一卓和副研究员杜长德作为共同第一作者,何晖光研究员为通讯作者,博士生李叙锦也参与了此项研究。研究工作得到了中国科学院战略性先导科技专项(XDB0930000)、北京市自然科学基金(L243016)以及国家自然科学基金(62206284 和 62020106015)的资助。为促进该领域的发展,研究团队即将把数据集、代码、模型权重开源。

论文地址:https://openreview.net/pdf?id=BpfsxFqhGa

开源代码地址:https://github.com/ReedOnePeck/Mind-Animator